当你开始编写 Apache Spark 代码可能欣赏果真的 API 的时候,你会碰着各类百般术语,好比transformation,action,RDD 等等。 相识到这些是编写 Spark 代码的基本。 同样,当你任务开始失败可能你需要透过web界面去相识本身的应用为何如此费时的时候,你需要去相识一些新的名词: job, stage, task。对付这些新术语的领略有助于编写精采 Spark 代码。这里的精采主要指更快的 Spark 措施。对付 Spark 底层的执行模子的相识对付写出效率更高的 Spark 措施很是有辅佐。

Spark 是如何执行措施的

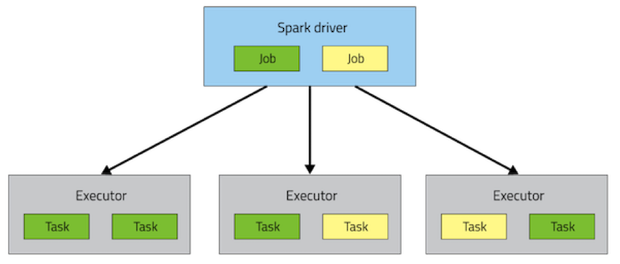

一个 Spark 应用包罗一个 driver 历程和若干个漫衍在集群的各个节点上的 executor 历程。

driver 主要认真调治一些高条理的任务流(flow of work)。exectuor 认真执行这些任务,这些任务以 task 的形式存在, 同时存储用户配置需要caching的数据。 task 和所有的 executor 的生命周期为整个措施的运行进程(假如利用了dynamic resource allocation 时大概不是这样的)。如何调治这些历程是通过集群打点应用完成的(好比YARN,Mesos,Spark Standalone),可是任何一个 Spark 措施城市包括一个 driver 和多个 executor 历程。

在执行条理布局的最上方是一系列 Job。挪用一个Spark内部的 action 会发生一个 Spark job 来完成它。 为了确定这些job实际的内容,Spark 查抄 RDD 的DAG再计较出执行 plan 。这个 plan 以最远端的 RDD 为起点(最远端指的是对外没有依赖的 RDD 可能 数据已经缓存下来的 RDD),

执行的 plan 由一系列 stage 构成,stage 是 job 的 transformation 的组合,stage 对应于一系列 task, task 指的对付差异的数据集执行的沟通代码。每个 stage 包括不需要 shuffle 数据的 transformation 的序列。

什么抉择命据是否需要 shuffle ?RDD 包括牢靠命目标 partition, 每个 partiton 包括若干的 record。对付那些通过narrow tansformation(好比 map 和 filter)返回的 RDD,一个 partition 中的 record 只需要从父 RDD 对应的partition 中的 record 计较获得。每个工具只依赖于父 RDD 的一个工具。有些操纵(好比 coalesce)大概导致一个 task处理惩罚多个输入 partition ,可是这种 transformation 仍然被认为是 narrow 的,因为用于计较的多个输入 record 始终是来自有限个数的 partition。

然而 Spark 也支持需要 wide 依赖的 transformation,好比 groupByKey,reduceByKey。在这种依赖中,计较获得一个 partition 中的数据需要从父 RDD 中的多个 partition 中读取数据。所有拥有沟通 key 的元组最终会被聚合到同一个partition 中,被同一个 stage 处理惩罚。为了完成这种操纵, Spark需要对数据举办 shuffle,意味着数据需要在集群内通报,最终生成由新的 partition 荟萃构成的新的 stage。

举例,以下的代码中,只有一个 action 以及 从一个文本串下来的一系列 RDD, 这些代码就只有一个 stage,因为没有哪个操纵需要从差异的 partition 内里读取数据。

sc.textFile("someFile.txt").

map(mapFunc).

flatMap(flatMapFunc).

filter(filterFunc).

count()

跟上面的代码差异,下面一段代码需要统计总共呈现高出1000次的单词:

val tokenized = sc.textFile(args(0)).flatMap(_.split(' '))

val wordCounts = tokenized.map((_, 1)).reduceByKey(_ + _)

val filtered = wordCounts.filter(_._2 >= 1000)

val charCounts = filtered.flatMap(_._1.toCharArray).map((_, 1)).

reduceByKey(_ + _)

charCounts.collect()

这段代码可以分成三个 stage。recudeByKey 操纵是各 stage 之间的分界,因为计较 recudeByKey 的输出需要凭据可以从头分派 partition。

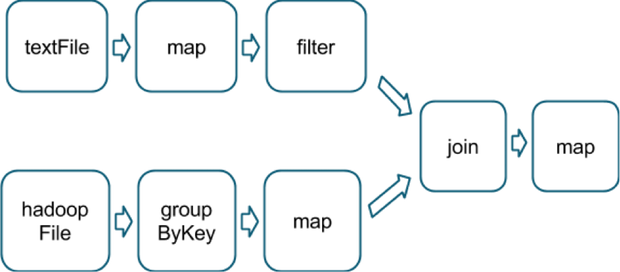

这里尚有一个越发巨大的 transfromation 图,包括一个有多路依赖的 join transformation。

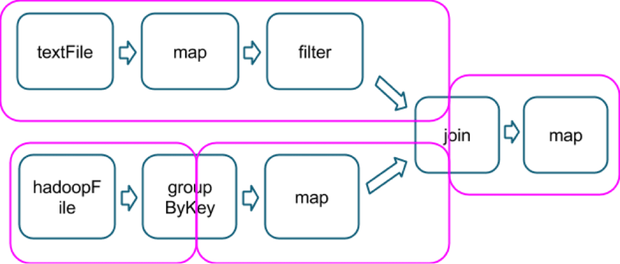

粉赤色的框框展示了运行时利用的 stage 图。

运行到每个 stage 的界线时,数据在父 stage 中凭据 task 写到磁盘上,而在子 stage 中通过网络凭据 task 去读取数据。这些操纵会导致很重的网络以及磁盘的I/O,所以 stage 的界线长短常占资源的,在编写 Spark 措施的时候需要只管制止的。父 stage 中 partition 个数与子 stage 的 partition 个数大概差异,所以那些发生 stage 界线的 transformation 经常需要接管一个 numPartition 的参数来以为子 stage 中的数据将被切分为几多个 partition。